- Home

- OKIの技術

- 技術広報誌 OKIテクニカルレビュー

- No.239

- 製造現場向け作業者の詳細な行動認識技術

技術広報誌 OKIテクニカルレビュー

センシング領域

- 本記事のリーフレット

製造現場向け作業者の詳細な行動認識技術

OKIでは、人手作業が欠かせない製造現場での、より高度な品質確保や工程管理などの実現を目指し、画像センシングを用いた作業者の行動認識技術を開発している。この技術により、対象人物の骨格などの用途に応じた有効な情報を動画像から抽出し、時系列ディープラーニングモデルの処理により一連の細かな行動の識別ができる。そのため、たとえば、製造ラインでの正しい作業手順判定や作業時間分析などに非常に有用な技術である。

本稿では、まず、詳細な行動認識技術を適用する製造現場での想定アプリケーションの例を示す。また、詳細な行動認識を支える要素技術を紹介する。さらに、自社工場のPHS組立工程への適用例を紹介する。

製造現場での想定アプリケーション

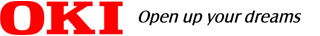

製造ラインでは、各工程の作業者行動をモニタリングすることおよびその内容を数値化することは、品質確保や生産性向上のために非常に重要である(参考文献1)。このような適用先に向け、画像センシングによる詳細な行動認識技術を活用して「現場を見える化」するアプリケーションの例を図1に示す。アプリケーション例①の「ポカヨケ」では、対象工程に必要な一連動作の順番やそれぞれの継続時間などを認識し作業者にタイムリーにフィードバックすることによってヒューマンエラーを防止できる。具体的なヒューマンエラーとしては、異なる部品取り付けや手順間違い、作業漏れなどが考えられる。アプリケーション例②の「作業分析」では、詳細な行動認識技術を活用し、製造ラインの改善に役立てる。具体的には、蓄積された認識結果である個々の工程の動作内容を数値化し統計分析することで、作業のばらつきやトラブル発生時の要因分析ができ、製造ラインの改善につながる。また、このような詳細な行動認識技術を利用したアプリケーションを現場で運用することにより、「副産物として膨大な作業映像を収集することができる。行動認識の結果と作業映像を利用して、未経験作業者の育成などにも活用できる。

図1 画像センシングを用いた行動認識技術の概要と想定アプリケーションの例

詳細な行動認識技術

画像センシングを用いた人物の行動認識は「『粗い』行動認識」(Coarse-grained Action Recognition)と「『詳細な』行動認識」(Fine-grained Action Recognition)に分類できる。「『粗い』行動認識」では、人物の体全体が映像中に映り、「走る」や「ジャンプする」や「座る」などの一般的な行動を認識する。このような行動の識別は、人物や背景などの「見え」情報および全体の「動き」情報を用いることで実現できる。一方、「『詳細な』行動認識」は、主に腕などの体の一部に注目し「モノを取る」や「モノを置く」などの何かの作業に関する一連の細かな動作を識別するという比較的難しいタスクである。そのため、識別対象の行動どうしを見分ける特徴選択や時系列情報を参照できる識別モデルの利用が重要となる。

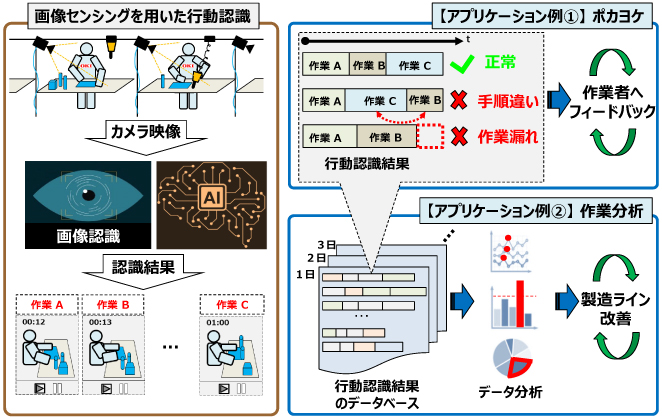

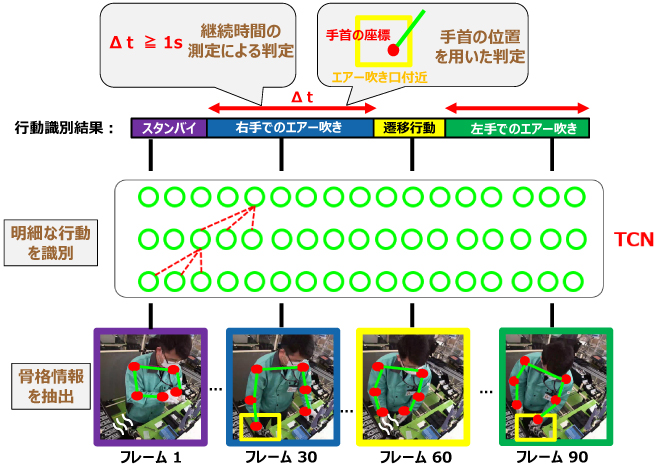

我々は、製造現場向けの作業者の詳細な行動認識を実現するために、用途に応じて「骨格情報などの有効な特徴」を抽出し「時系列ディープラーニング技術」を用いて識別処理を行う。また、アプリケーションによって行動識別結果の時系列情報から、作業手順の正しさや作業の継続時間、また同様の手順を行った回数などを用いて作業自体の良否を判定する(図2)。以降に詳細な行動認識を実現するための要素技術を紹介する。

図2 詳細な行動認識を支える要素技術

(1)骨格情報などの有効な情報の抽出技術

製造ラインでの部品組立や加工などさまざまな工程で起こる動作(「パーツを取り付ける」や「ネジを締める」など)の認識を想定し、背景・服装に依存しない作業者の姿勢や腕などの関節位置とその変化情報が重要だと考える。従って、行動識別のために基本的には映像の各フレームから作業者の骨格情報を用いる。骨格情報の抽出方法は、OpenPose(参考文献2)に代表されるディープラーニングを利用した手法が多数提案され、さまざまなシーンに対して共通的に利用できる。

また、手順間違い判定などのアプリケーションでは、同じような動作に対して向きを見分ける必要がある際に、骨格情報に加えてオプティカルフローなどの向きを示す情報を利用することができる。さらに、異なる部品取付け判定などの用途では、部品を検出したうえでその位置・領域情報の利用も重要である。

(2)時系列ディープラーニング技術

作業者が行っている動作を識別するために、抽出した骨格情報などの特徴の時系列的な変化をモデリングする必要がある。一般に、時系列の骨格情報を用いた行動識別のディープラーニング技術はRNN(Recurrent Neural Network)、CNN(Convolutional Neural Network)、TCN(Temporal Convolutional Network)、GCN(Graph Convolutional Network)がある(参考文献3)。我々は、処理速度が比較的速く、骨格情報以外の特徴と組合せやすいTCNを用いる。TCN(参考文献4)は、画像認識分野で広く用いられている一般的な畳み込み処理(Convolution)を時間軸方向に適用した時系列畳み込み処理(Temporal Convolution)を用いることで、ある時刻の前後の時系列情報をもとに行動を認識する。時系列畳み込み処理を複数回行うことで、長時間の時系列情報を効率よく扱い、精度の高い行動認識が実現できるようになる。また、ディープラーニング技術の発展とともに画像認識分野の畳み込み処理に対して行われてきた改良を応用することができ、より複雑な行動を認識することも可能となる。このようにTCNは、高い汎用性を持ち、さまざまな改良を行うことができるため、さまざまな工程の現場に共通的に適用可能だと考える。

自社工場での応用事例

詳細な行動認識技術を適用して、OKI本庄工場のPHS組立工程で異物を除去するエアー吹き作業に対して、作業の良否を判定する行為判定システム(参考文献5)を検討している。背景として、エアー吹きでの作業漏れ・ミスがあった場合も後工程の検査で不良検出が困難なことがある。検査工程での不良検出が難しいため、作業自体の良否を判定することが非常に重要である。以降にシステム概要および詳細な行動認識技術の適用について述べる。

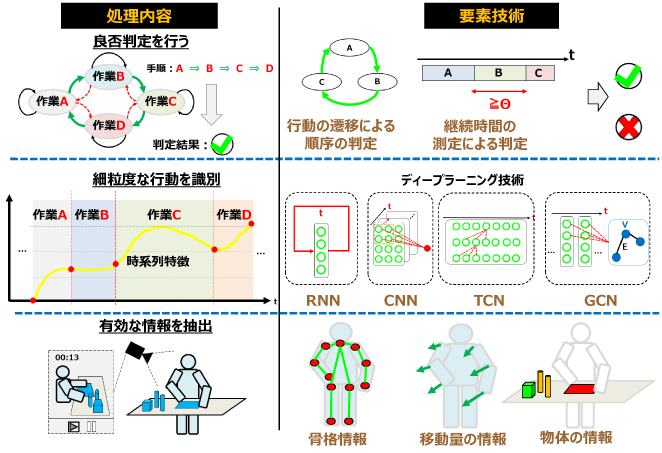

(1)システム概要

想定する行為判定システム(図3)は、作業者が作業を行う場面をカメラで撮影し、エッジ端末などにより画像認識技術を用いて作業内容や作業手順が正しかったかどうかを判定する。その判定結果を作業者へリアルタイムに通知することで、作業者はその場で作業漏れ、作業ミスに気付くことができる。また、判定結果を管理サーバーに保存することで作業行為の証跡データとして活用できる。

図3 行為判定システム

(2)エアー吹き作業での行為判定実現方法

エアー吹き作業は、作業者がPHSカバーを左右の手に持ち、作業台に設置してあるエアー吹き口に当ててカバーについた粉塵をエアーにより除去する作業である(図4)。主に作業者の両腕の動きが中心となるため、両腕の「肩」・「肘」・「手首」の関節を骨格情報として抽出し行動の識別に利用する。また、TCNを用いて識別対象となる行動として左右どちらの手でエアー吹きしているかを識別する。

図4 PHSエアー吹き作業

望ましいエアー吹きは、所定の時間以上実施していることおよびPHSカバーにエアーがきちんと当たったことが条件となる。従って、行動識別結果の時系列情報から継続時間を測定し、PHSカバーを持っている手の手首位置がエアー吹き口付近である所定の領域内にあるかどうかで良否を判定する(図5)。

図5 エアー吹き作業での行為判定

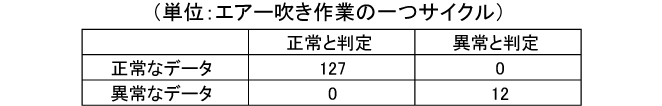

(3)実現技術の検証

行動認識技術を用いたエアー吹き作業に対する行為判定の有効性を確認するために検証した。検証データを収集するために実際のPHS組立ラインでの正常なエアー吹き作業を撮影した。この正常データは行動識別するTCNの訓練および検証に用いる。また、作業漏れ・作業ミスのあるエアー吹きを実際の作業台で演じることで検証用の異常データを撮影した。検証結果では、正常なエアー吹きに対して誤判定がなく、異常なエアー吹きの判定漏れは起きなかった(表1)。この結果により、詳細な行動認識技術による行為判定がPHSエアー吹きでの作業漏れ・作業ミスの防止に有効であることを示した。今後は、現場で稼働するシステムを構築していく予定である。

表1 行為判定の結果

まとめと今後の展望

本稿では、画像センシングを用いた作業者の詳細な行動認識技術とその応用事例を紹介した。この技術は、動画像から対象人物の骨格推定による特徴などの用途に応じた有効な情報を抽出し、時系列ディープラーニングモデル処理により一連の細かな行動識別ができる。また、具体的な応用事例であるPHS組立工程でのエアー吹きに、詳細な行動認識技術を用いることで作業漏れ・作業ミスを防止できることを示した。

現在、人手作業が欠かせない製造現場で、さまざまなタスクに対し詳細な行動認識の適用検討を継続している。今後、「匠の技」のような高度なモデリングのためにより細粒度な行動認識の実現に向けた研究開発を行っていく予定である。

参考文献

(参考文献1)Improving Manual Assembly Lines at Scale,Drishti Technologies Inc,2021.

(参考文献2)Cao et al.:"OpenPose:Realtime Multi-person 2D Pose Estimation using Part Affinity Fields",TPAMI,2019.

(参考文献3)Sun et al.:Human Action Recognition from Various Data Modalities:A Review,ArXiv,2021.

(参考文献4)Lea et al.:Temporal Convolutional Networks for Action Segmentation and Detection,CVPR,2017.

(参考文献5)川面怜哉、浅野将仁、蘭浩二、山本一真、小林司:作業内容や作業手順の正しさを判定する行為判定システム、OKIテクニカルレビュー第238号、Vol.88 No.2、pp.46-49、2021年11月

筆者紹介

ファンチョンフィ:Phan Trong Huy. イノベーション推進センター センシング技術研究開発部

上野鷹幸:Takayuki Ueno. イノベーション推進センター センシング技術研究開発部

山本一真:Kazuma Yamamoto. イノベーション推進センター センシング技術研究開発部

用語解説

- ポカヨケ

- 工場などの製造ラインに設置し、作業者のミス(ポカ)をよける(ヨケる)ための装置や仕組みのこと。

- オプティカルフロー(Optical Flow)

- フレーム間物体の動きを検出して速度をベクトルで表示する手法。